Crawl là gì? 5 lỗi khiến Google không thể crawl data website đúng cách

Để người khác có thể tìm thấy trang web của bạn, trình thu thập thông tin của công cụ tìm kiếm hay còn gọi là crawler sẽ cử các bot thu thập dữ liệu trang web, crawl data, tìm kiếm văn bản và liên kết và cập nhật chỉ mục tìm kiếm của chúng. Từ đó, nội dung của bạn sẽ được Google hiển thị trong kết quả tìm kiếm liên quan nhất. Bài viết của Ori Agency nêu bật các khía cạnh quan trọng về crawl là gì, tầm quan trọng với SEO, cách thức hoạt động, cách giúp Google thu thập thông tin website đúng cách,...

Mục Lục

- I - Khái niệm Crawl

- II - Crawler ảnh hưởng đến SEO như thế nào?

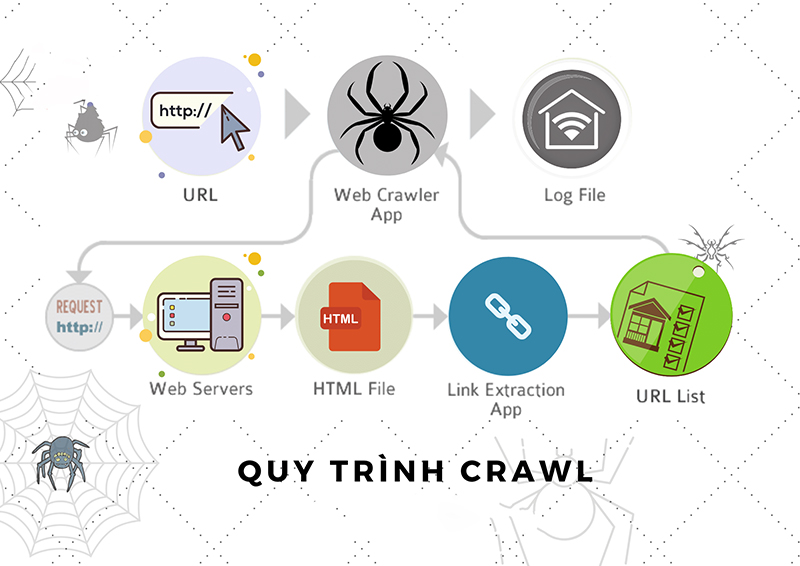

- III - Trình thu thập thông tin (Crawler) hoạt động như thế nào?

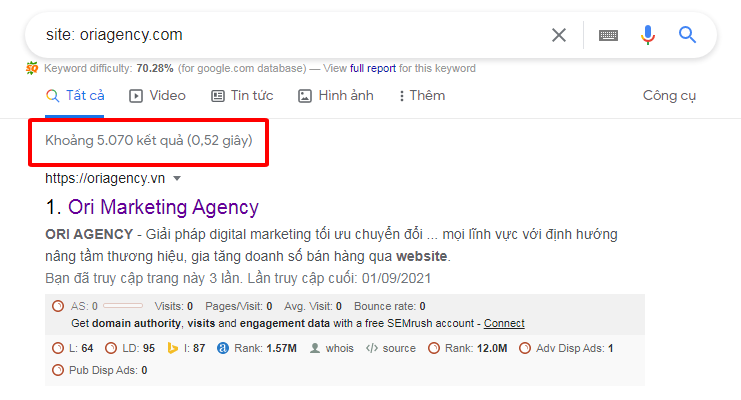

- IV - Crawl data: Công cụ tìm kiếm có thể tìm thấy các trang của bạn không?

- V - Một số lỗi khiến Googlebot không thể Crawl trang web của bạn

- VI - Giúp công cụ tìm kiếm biết cách crawl trang web của bạn

- VII - Chặn Google crawl website

- Tags